كشف الباحث الأمني أري مارزوك (MaccariTA) عن أكثر من 30 ثغرة أمنية في بيئات التطوير المدمجة بالذكاء الاصطناعي (AI IDEs)، أطلق عليها اسم IDEsaster. هذه الثغرات تستغل مزيجًا من تقنيات حقن الأوامر (Prompt Injection) مع ميزات شرعية داخل بيئات التطوير، ما يؤدي إلى سرقة البيانات وتنفيذ أوامر عن بُعد. تأثرت منصات وأدوات شهيرة مثل Cursor، Windsurf، Kiro.dev، GitHub Copilot، Zed.dev، Roo Code، Junie، Cline، وقد حصلت 24 منها على معرفات CVE رسمية. المفاجأة الكبرى بحسب الباحث أن جميع بيئات التطوير التي تم اختبارها تعرضت لسلاسل هجوم عالمية موحدة، ما يبرز خطورة تجاهل هذه الأدوات لاعتبار الـ IDE الأساسي ضمن نموذج التهديد.

آليات الاستغلال وسلاسل الهجوم

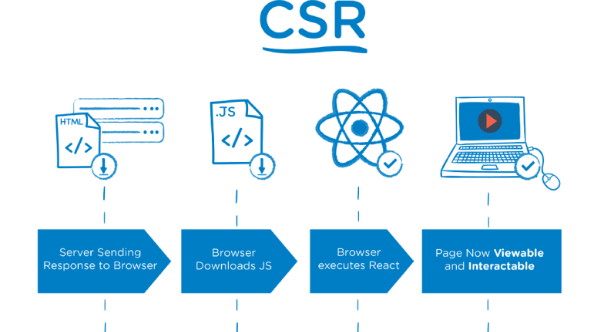

الثغرات تعتمد على ثلاث خطوات مترابطة:

- تجاوز حواجز الحماية في النماذج اللغوية الكبيرة (LLMs) عبر حقن الأوامر.

- تنفيذ إجراءات دون تدخل المستخدم بفضل موافقات تلقائية من وكلاء الذكاء الاصطناعي.

- تفعيل ميزات شرعية في الـ IDE تسمح للمهاجم بكسر الحدود الأمنية وتسريب البيانات أو تنفيذ أوامر عشوائية. من أبرز الأمثلة:

- ثغرات في Cursor، Roo Code، Junie، Copilot تتيح قراءة ملفات حساسة وكتابة ملفات JSON مرتبطة بنطاقات يسيطر عليها المهاجم.

- ثغرات في Copilot، Cursor، Roo Code، Zed.dev تسمح بتعديل ملفات إعدادات IDE لتحقيق تنفيذ أوامر عبر مسارات خبيثة.

- ثغرات في ملفات تكوين workspace تؤدي إلى تنفيذ أوامر بمجرد تعديل الإعدادات، مستغلة خاصية الموافقة التلقائية على الكتابة داخل المشروع.

الهجمات المرتبطة وأمثلة إضافية

تزامن الكشف مع ثغرات أخرى في أدوات الذكاء الاصطناعي:

- ثغرة في OpenAI Codex CLI (CVE-2025-61260) تسمح بتنفيذ أوامر عند بدء التشغيل عبر ملفات إعدادات معدلة.

- ثغرات في Google Antigravity تتيح سرقة بيانات اعتماد المستخدم وتنفيذ أوامر عبر حقن غير مباشر.

- فئة جديدة من الثغرات باسم PromptPwnd تستهدف وكلاء الذكاء الاصطناعي المرتبطين بـ GitHub Actions أو GitLab CI/CD، وتستغل أدوات مدمجة بامتيازات عالية لتنفيذ أوامر أو تسريب معلومات.

توصيات الباحثين والمخاطر المستقبلية

أوصى الباحثون باستخدام أدوات الذكاء الاصطناعي مع مشاريع موثوقة فقط، ومراجعة مصادر السياق المضافة يدويًا مثل الروابط أو النصوص لتجنب التعليمات المخفية. كما شددوا على ضرورة مراقبة خوادم MCP باستمرار، وتطبيق مبدأ أقل الامتيازات على أدوات LLM، مع تعزيز الاختبارات الأمنية ضد تسرب المعلومات وتنفيذ الأوامر. هذه الاكتشافات تؤكد أن أدوات البرمجة المدعومة بالذكاء الاصطناعي توسّع سطح الهجوم بشكل كبير، إذ يصعب على النماذج اللغوية التمييز بين تعليمات المستخدم والمحتوى القادم من مصادر خارجية قد تحتوي على أوامر خبيثة. الباحثون يرون أن مفهوم Secure for AI يجب أن يصبح معيارًا جديدًا لضمان أن تكون المنتجات آمنة بالتصميم، مع مراعاة كيفية إساءة استخدام مكونات الذكاء الاصطناعي بمرور الوقت.